Verzerrtes Bauchgefühl

Sich für kompetenter zu halten, als man tatsächlich ist; oder zu glauben, man hätte ein sehr unwahrscheinliches Ereignis schon von Anfang an kommen sehen: Wenn wir intuitiv denken, statt analytisch, dann kommt es auch mal zu kognitiven Verzerrungen.

Wissenschaftliche Betreuung: Prof. Dr. Axel Mecklinger

Veröffentlicht: 22.01.2015

Niveau: mittel

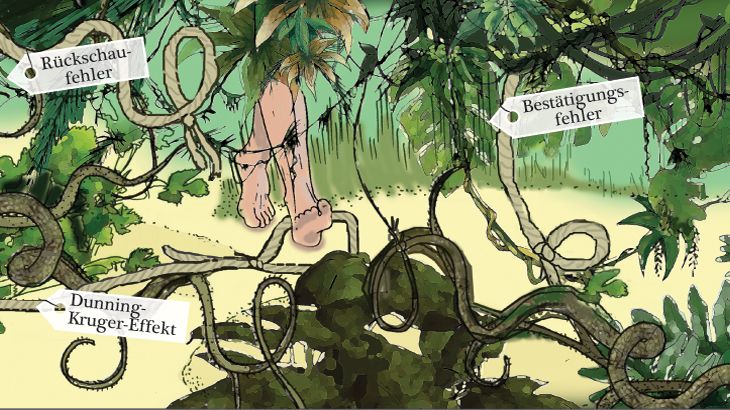

- Ganz allgemein unterliegen wir in unserem Leben häufig kognitiven Verzerrungen (im Englischen „Cognitive Bias“). In Denkfallen hinein tappt besonders unsere Intuition: Sie versorgt uns immer wieder mit schnellen und automatischen Antworten auf Fragen und Situationen des Lebens, macht dabei aber auch Fehler.

- Der Dunning-Kruger-Effekt besagt, dass Menschen systematisch ihre Fähigkeiten in bestimmten Bereichen des Lebens überschätzen. Sie treffen dann in diesen Bereichen unglückliche Entscheidungen – und gleichzeitig beraubt sie ihre Inkompetenz auch der Fähigkeit, ihr eigenes Unvermögen einzusehen.

- Der Bestätigungsfehler (im Englischen „Confirmation Bias“) wiederum lässt uns nur Informationen über uns oder die Welt suchen, die zu unseren Erwartungen passen.

- Auch der Blick zurück fällt oftmals verzerrt aus. Nimmt man eine neue Haltung zu einem Thema wie Todesstrafe ein, kann man sich wegen des Rückschaufehlers (im Englischen „Hindsight Bias“) nicht mehr an die eigene ursprüngliche Position erinnern. Außerdem neigen wir dazu, in der Rückschau auch Ereignisse als sehr wahrscheinlich zu betrachten, die eigentlich unvorhersehbar waren.

- Und zu guter Letzt lässt uns die Clustering-Illusion Muster in einer Abfolge rein zufälliger Ereignisse erkennen, obwohl überhaupt keine Muster vorhanden sind.

Menschen neigen dazu zu glauben, sie hätten Situationen unter ihrer Kontrolle, die sie in Wahrheit gar nicht beeinflussen können. Die Psychologin Ellen Langer von der Harvard University gab diesem Phänomen seinen Namen. Ein perfektes Beispiel um die „Kontrollillusion“ zu studieren, fand Langer in den 1970er Jahren bei der Teilnahme an Lotterien. Schließlich ist das Ergebnis, ob man gewinnt oder nicht, purer Zufall. Dennoch zeigte sich: Probanden, die ihre Lotterielose selbst auswählen konnten, schätzten ihre Gewinnerwartungen höher ein als solche, die ihre Lose zugewiesen bekamen. Ganz so als könnten sie das zufällige Ergebnis durch die Wahl des Loses beeinflussen.

1995 überfiel McArthur Wheeler zwei Banken in Pittsburgh, USA, ohne jeden erkennbaren Versuch, sich zu maskieren. Kurz nachdem die Videoaufnahmen von ihm in den Nachrichten liefen, wurde er von der Polizei verhaftet. Als man ihm das Überwachungsvideo zeigte, rief er ungläubig aus: „Aber ich hatte doch den Saft an.“ Saft? Ja, Saft. Bankräüber Wheeler glaubte wahrscheinlich, sein Gesicht mit Zitronensaft einzureiben, würde ihn für die Überwachungskamera unsichtbar machen.

Die Psychologen Justin Kruger von der New York University und David Dunning von der Cornell University ließen sich 1999 von dieser skurrilen Geschichte zu einer mittlerweile bekannten Studie inspirieren. Ihre Hypothese: Menschen schätzen systematisch ihre eigenen Fähigkeiten in bestimmten Bereichen falsch ein. Denn McArthur Wheeler wusste offensichtlich nicht, wie man ein Verbrechen erfolgreich verübt: Er dachte auch noch, dass er seinen „Job“ gut macht.

Wie Kruger und Dunning feststellen mussten, ging es nicht nur Wheeler so, sondern auch den Studienteilnehmern, gebildeten Collegestudenten. Jene Probanden, die bei Aufgaben aus den Bereichen Logik und englische Grammatik unterdurchschnittlich abgeschnitten hatten, überschätzten ihre Ergebnisse und ihre Fertigkeiten systematisch. Sie hielten sich gar für überdurchschnittlich!

Kruger und Dunning erklärten sich den Effekt so: Wenn Menschen Strategien nicht beherrschen, die in einem bestimmten Bereich des Lebens für erfolgreiches Handeln notwendig sind, dann haben sie mit einer doppelten Last zu kämpfen – zum einen treffen sie unglückliche Entscheidungen, zum anderen beraubt ihre Inkompetenz sie auch der Fähigkeit, ihr eigenes Unvermögen einzusehen. Denn die Fertigkeiten, die in einem bestimmten Bereich die Kompetenz ausmachen, sind oftmals zugleich auch die Fähigkeiten, um das Fachwissen in diesem Bereich beurteilen zu können. Die Fähigkeit etwa einen grammatikalisch korrekten Satz zu bilden, ist gleichzeitig auch die Fähigkeit, um beurteilen zu können, ob man selbst oder ein anderer einen grammatikalischen Fehler gemacht hat.

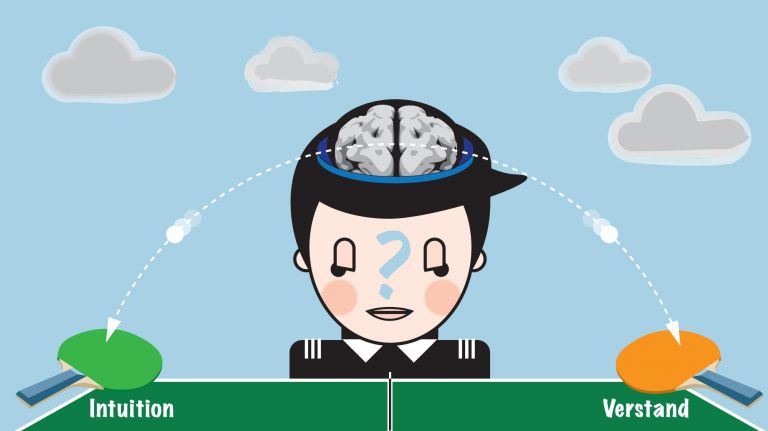

Dieser Effekt wird mittlerweile auch Dunning-Kruger-Effekt genannt. Und er ist ein Beispiel dafür, wie uns unser Denken immer wieder einen Streich spielt: Das sind so genannte kognitive Verzerrungen (im Englischen „Cognitive Bias“). Besonders anfällig für Denkfallen ist unsere Intuition, die uns immer wieder mit schnellen und automatischen Antworten auf Fragen und Situationen des Lebens versorgt (Unbewusstes Denken statt sechsten Sinns). Das hat vor allem die jahrzehntelange Forschung des israelisch-amerikanischen Psychologen Daniel Kahneman gezeigt, der 2002 als bislang einziger Psychologe den Wirtschaftsnobelpreis erhalten hat. Die Ursachen dieser Verzerrungen sieht Kahnemann vor allem darin, dass unser intuitives Denken wenig von Logik versteht, sich vereinfachte Geschichten über die Wirklichkeit ausdenkt und sich in seinem Urteil auch von Emotionen leiten lässt.

Emotionen

Emotionen/-/emotions

Unter „Emotionen“ verstehen Neurowissenschaftler psychische Prozesse, die durch äußere Reize ausgelöst werden und eine Handlungsbereitschaft zur Folge haben. Emotionen entstehen im limbischen System, einem stammesgeschichtlich alten Teil des Gehirns. Der Psychologe Paul Ekman hat sechs kulturübergreifende Basisemotionen definiert, die sich in charakteristischen Gesichtsausdrücken widerspiegeln: Freude, Ärger, Angst, Überraschung, Trauer und Ekel.

Nur sehen, was man sehen möchte

Wenn Sie viel von Intuition halten, werden Sie diesen Text möglicherweise nicht zu Ende lesen. Warum? Auf Grund einer weiteren kognitiven Verzerrung. Wir neigen nämlich intuitiv dazu, Informationen danach auszuwählen, ob sie zu unseren Erwartungen und Überzeugungen passen. Und ein Text, der die Schwächen der Intuition offenlegt, obwohl man selbst an dieses Bauchgefühl glaubt: Das würde sich nun mal nicht so gut mit Ihrer eigenen Haltung vertragen. Dieser so genannte Bestätigungsfehler (im Englischen „Confirmation Bias“) ist besonders stark am Werk bei emotional aufgeladenen und tief verwurzelten Überzeugungen. Und er hilft damit auch, so manches Vorurteil und Klischee zu zementieren.

Nehmen wir an, jemand nimmt Ihnen an einer Kreuzung die Vorfahrt. Sie können gerade noch rechtzeitig bremsen und einen schlimmen Unfall verhindern. Der Ärger entlädt sich so richtig, als Sie erkennen, wer da hinter dem Steuer des schuldigen Wagens sitzt: „Eine Frau, natürlich! Frauen können wirklich nicht fahren.“ Das wird Ihnen vor allem durch den Kopf schießen, wenn Sie selbst ein Mann sind. Aber auch so mancher Frau geht es so. Und das Vorurteil über die weiblichen Fahrkünste scheint sich einmal mehr zu bewahrheiten.

Emotionen

Emotionen/-/emotions

Unter „Emotionen“ verstehen Neurowissenschaftler psychische Prozesse, die durch äußere Reize ausgelöst werden und eine Handlungsbereitschaft zur Folge haben. Emotionen entstehen im limbischen System, einem stammesgeschichtlich alten Teil des Gehirns. Der Psychologe Paul Ekman hat sechs kulturübergreifende Basisemotionen definiert, die sich in charakteristischen Gesichtsausdrücken widerspiegeln: Freude, Ärger, Angst, Überraschung, Trauer und Ekel.

Empfohlene Artikel

Der trügerische Blick zurück

Doch wie oft haben Sie wahrscheinlich in der Vergangenheit unbewusst erlebt, dass Frau sich geradezu vorbildlich an die Straßenverkehrsordnung hält und Mann nicht gerade mit fahrerischem Können geglänzt hat? Das hat Sie aber gerade eben nicht dazu gebracht, das Vorurteil über miserable Autofahrerinnen zu überdenken.

Auch sonst bietet der Blick zurück so manche Fallstricke. „Das Gehirn, das sich Narrative über die Vergangenheit ausdenkt, ist ein sinnstiftendes Organ“, schreibt der bereits erwähnte Psychologe Daniel Kahneman in seinem Buch „Schnelles Denken, langsames Denken“. Es habe einen Hang, die Geschichte der Vergangenheit neu zu schreiben. Ändern etwa Probanden im Laufe einer Studie ihre Meinung zur Todesstrafe, fällt es ihnen am Ende des Experiments schwer, ihre ursprüngliche Haltung zu rekonstruieren. Stattdessen erinnern sie sich nur an ihre momentane Position. Und viele von ihnen können nicht glauben, dass sie jemals eine andere Meinung hatten!

Diese Verzerrung unseres Denkens wird als Rückschaufehler (im Englischen „Hindsight Bias“) bezeichnet. Eine Form des Rückschaufehlers ist der „Ich wusste es die ganze Zeit“-Effekt. Denn wir neigen dazu, in der Rückschau auch Ereignisse als sehr wahrscheinlich zu betrachten, die eigentlich unvorhersehbar waren, etwa unerwartete politische Geschehnisse oder der überraschende Ausgang von sportlichen Wettkämpfen. Mitunter lässt sich der Fehler sogar beziffern, etwa wenn man Wahlergebnisse mit Wahlprognosen vergleicht.

Daniel Kahneman zufolge schadet der Rückschaufehler der Beurteilung von Entscheidungsträgern wie Politikern oder Ärzten. Man prüft häufig nicht, ob der Prozess der Entscheidungsfindung selbst fehlerfrei war, sondern, ob die Folgen des Entschlusses positiv oder negativ ausfielen. Ein Beispiel wäre ein chirurgischer Eingriff mit geringem Risiko, bei dem sich ein unvorhergesehener Zwischenfall ereignet wie der Tod des Patienten. Im Rückblick, so Kahneman, würden etwa Geschworene in einem amerikanischen Gericht davon ausgehen, dass die Operation von Anfang an risikoreich gewesen war: Der die OP anordnende Arzt hätte es einfach besser wissen müssen. Ein Denkfehler – aber nicht des Arztes, sondern der Geschworenen.

Nach Kahneman lässt uns die Sinngebungsmaschinerie unseres unbewussten intuitiven Systems die Welt geordneter, einfacher, vorhersagbarer wahrnehmen, als sie es tatsächlich ist. Die Illusion, die Vergangenheit verstanden zu haben, nähre die Illusion, man könne die Zukunft vorhersagen. Diese Illusionen wirkten auf den Menschen beruhigend.

Muster-Erkennung ohne Grund

Die Suche nach Sinn steckt wohl auch hinter der so genannten Clustering-Illusion (vom Englischen Cluster: „Häufung“). Nehmen wir wieder ein Beispiel: In einer epidemiologischen Studie taucht ein spontan bemerkenswert erscheinendes Muster auf: Landkreise in den USA mit der niedrigsten Nierenkrebs-Häufigkeit liegen vorwiegend in dünn besiedelten, ländlichen Bundesstaaten, in denen traditionell die konservativen Republikaner gewählt werden. Intuitiv suchen Sie nun wahrscheinlich nach einem Zusammenhang, einem Muster, einer Ursache. Könnte die niedrigere Krebsrate mit den Republikanern zusammenhängen? Wohl kaum. Aber bestimmt liegt es doch an der ländlichen Umgebung, in der schließlich die Schadstoffbelastung niedriger ausfällt. Das klingt schon plausibler.

Das Problem ist nur: Auch die Landkreise mit der höchsten Nierenkrebs-Häufigkeit lagen ebenfalls in dünn besiedelten, ländlichen Regionen, in denen traditionell die Republikaner gewählt werden. Die Lösung hat nichts mit versteckten Mustern oder Ursachen zu tun, sondern mit Statistik: Die untersuchten Stichproben in ländlichen Gebieten sind im Allgemeinen kleiner als solche aus Städten. Und kleinere Stichproben zeigen extremere Ergebnisse – in diesem Fall sehr hohe und sehr niedrige Krebsraten, die in dem Zeitraum der Erhebung einfach Zufall waren. Die Clustering-Illusion ist eben die falsche Intuition, dass hinter einer Reihe von zufälligen Ereignissen ein Muster steckt. Gerne wird diese Denkfalle mit einer großen Serie von Punkten veranschaulicht, die rein zufällig angeordnet sind – während wir dennoch dazu neigen, hierin ein Muster erkennen zu wollen.

Ein etwas populäreres Beispiel stammt aus dem Sport: Beim Basketball nehmen Fans, Trainer und Spieler gerne an, dass Spieler eine besondere „Strähne“, einen „Lauf“ haben können, wobei sie nach einem erfolgreichen Wurf mit höherer Wahrscheinlichkeit auch einen nächsten Treffer landen. Analysen von Basketball-Spielen zeigen allerdings, dass es keine wirklichen „Strähnen“ gibt, jedenfalls keine, die außerhalb des Rahmens der normalen Wahrscheinlichkeiten liegen. Auch beim Sport tendieren Menschen somit dazu, ein Muster in einer gewissermaßen „zufälligen“ Reihe von Ereignissen zu erkennen.

Sie sehen also: Es kann nicht schaden, ab und an die eigene Intuition kritisch zu hinterfragen.

zum Weiterlesen:

- Kahneman, Daniel: Schnelles Denken, langsames Denken, München 2011.