KI – Risiken und Nebenwirkungen

Autonome intelligente Waffen, Überwachung von Bürgern durch Algorithmen oder eine Superintelligenz, die sich gegen den Menschen richtet: Bei allen Annehmlichkeiten birgt künstliche Intelligenz reale und potenzielle Gefahren.

Wissenschaftliche Betreuung: Prof. Dr. Thomas Brox

Veröffentlicht: 30.05.2019

Niveau: leicht

- KI ist eine Dual-Use-Technologie. Sie kann sowohl für friedliche Ziele als auch für militärische Zwecke genutzt werden

- Das Militär arbeitet an autonomen intelligenten Waffensystemen. Die Gefahr des Missbrauchs liegt hier auf der Hand.

- Es gibt aber auch subtilere Risiken. Wie etwa künstliche neuronale Netze zu ihren Entscheidungen gelangen, ist vielfach nicht mal für ihre Entwickler klar. Und teilweise übernehmen sie auch menschliche Vorurteile.

- Über Algorithmen und personalisierte Informationen können Unternehmen unser Denken und unsere Entscheidungen beeinflussen.

- China geht mit seinem Social Credit-System und intelligenter Überwachungstechnik noch einen Schritt weiter: Von dem jeweiligen Punktestand eines Menschen hängt ab, welchen Beruf er ergreifen kann und in welche Länder er reisen darf

- Nicht ausschließen lässt sich ein Worst-Case-Szenario: Eine künstliche Superintelligenz, die der menschlichen Intelligenz überlegen ist und sich gegen den Menschen wendet.

- Maßnahmen gegen die Gefahren einer KI könnten in einem internationalen Moratorium bestehen und in der Aufklärung der Gesellschaft über die Risiken der KI.

Wie ein Virus verbreitet es sich auf Millionen Computerservern um die ganze Welt. Und das Unvorstellbare passiert. Es erlangt Bewusstsein und richtet sich gegen seine eigenen Schöpfer: Für das Militär entwickelt, erkennt das KI-System Skynet im Jahre 2029, dass die Menschen es als Gefahr ansehen und ihm deshalb den Stecker ziehen wollen. Um sein eigenes Überleben zu sichern, befiehlt Skynet daher Servern, Satelliten, digitalen Kampfgeräten und Cyborgs in den Krieg gegen die Menschheit zu ziehen, der in der Apokalypse endet.

Diese Zukunftsvision aus dem Film „Terminator“ ist vielleicht das berühmteste KI-Schreckensszenario, – und es hat wieder an Aktualität gewonnen. Über die Jahrzehnte hinweg haben sich in der KI immer wieder Phasen der Euphorie mit langen Jahren der Ernüchterung abgewechselt. Doch nun scheint die KI-Forschung mit dem Erfolg von tiefen neuronalen Netzen (Deep neural networks) endgültig durchzustarten: mit Quantensprüngen etwa bei der Gesichtserkennung oder der automatisierten Übersetzung. Zunächst einmal ist KI natürlich im Grunde eine Dual-Use-Technologie: Man kann sie sowohl für friedliche Ziele einsetzen, als auch für militärische Zwecke nutzen. Sie kann für uns harte, gefährliche oder einfach nur langweilige Arbeit übernehmen. Sie beflügelt viele Bereiche wie die Medizin, etwa in Gestalt von IBMs KI-System Watson, das teilweise jetzt schon mit besseren Diagnosen als Ärzte aufwarten kann. Von dem täglichen Luxus des Smartphones oder Internetsuchmaschinen einmal ganz abgesehen.

Doch wie schon im Film Terminator treibt auch in der wirklichen Welt neben IT- und Internetkonzernen das Militär die Entwicklung der KI voran. Erst 2018 kündigte die Defense Advanced Research Projects Agency (DARPA), die Behörde für militärische Forschungs-Projekte des US-Verteidigungsministeriums, Investitionen in Höhe von zwei Milliarden US-Dollar an. Ziel ist die Entwicklung einer KI, die selbstständig auf veränderte Situationen reagieren können soll. Das US-Verteidigungsministerium betrachtet KI als eine Schlüsseltechnologie in der Waffentechnik. Man verspricht sich davon Waffensysteme, die eigene Entscheidungen treffen können und militärische Vorteile in Form von kürzeren Reaktionszeiten bringen.

Doch genau in den immer kürzeren Reaktionszeiten intelligenter Waffensysteme wie Drohnen oder Kampfrobotern liegt eines der zentralen Probleme. Denn diesen Geschwindigkeitsvorteil würde man wieder verlieren, wenn sich die Systeme zu oft bei ihren menschlichen Herren rückversichern würden. Der Mensch müsste also Kontrolle abgeben. Ein weiteres Problem benennt der Informatiker Fred Hamker von der TU Chemnitz: Natürlich bestehe immer die Gefahr, dass die Waffen von Gruppen oder Staaten genutzt werden, denen man nicht vertrauen kann. "Während bei Atomwaffen deren Abschreckungspotential einen Krieg wohl verhindern würde, ist ein Krieg mit KI-bestückten Kleinwaffen schon eher denkbar."

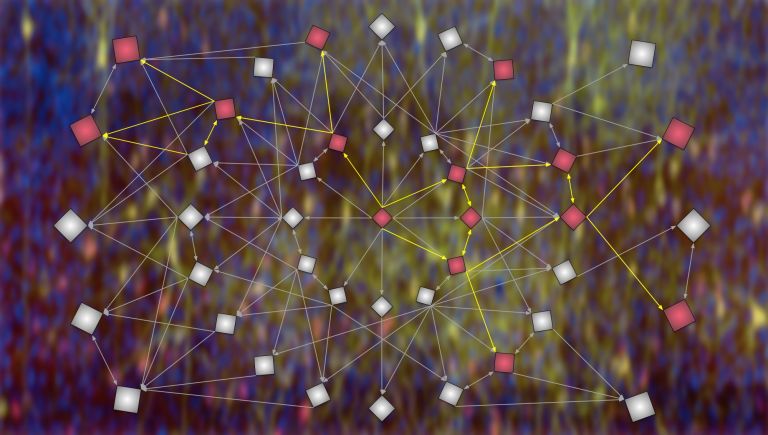

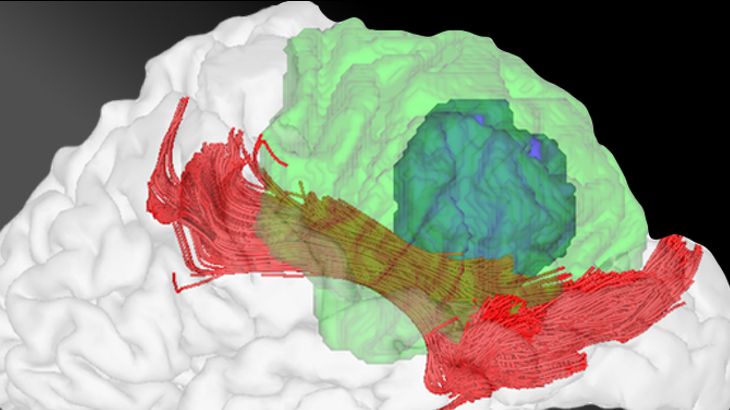

Doch es gibt auch Risiken und Nebenwirkungen von KI, die nicht martialisch, sondern wesentlich subtiler daherkommen. So stellen die äußerst beliebten tiefen neuronalen Netze selbst für ihre Entwickler im Grunde eine Black Box dar. Was bei einerKI zwischen Ein- und Ausgabe passiert, können sie nur erahnen. Ähnlich wie im Gehirn sind die für das Lernen wichtigen Informationen dezentral im neuronalen Netz lokalisiert, in der Stärke einer Vielzahl von Verbindungen verschlüsselt und nicht an einem ganz bestimmten Ort abgelegt. Wodurch genau ein neuronales Netz etwa erfolgreich ein Auto von einem Baum unterscheidet, ist damit gar nicht so leicht nachvollziehbar. Und das ist nicht nur von akademischem Interesse. Denn nehmen wir einmal an, ein Netz glaubt, auf einer Mammografie Brustkrebs auszumachen, was die beteiligten Ärzte aber nicht erkennen. Sollen die Ärzte ihm vertrauen, wenn sie überhaupt nicht wissen, wie es zu seinen Schlüssen gelangt ist?

Die nicht immer durchsichtigen Entscheidungen von KI-Systemen können im Zweifelsfall dazu führen, dass diese dem Menschen mehr ähneln als uns lieb sein kann. Mittlerweile ist nämlich klar: KI können auch Vorurteile hegen. Das fanden Forscher um Aylin Caliskan von der Princeton University heraus. Sie stellten dabei GloVe, eine Sprach-KI für die Analyse von semantischen Zusammenhängen, auf die Probe. Dabei griffen sie auf eine psychologische Methode zum Registrieren von Vorurteilen zurück, den Impliziten Assoziationstest, – und passten ihn für die Untersuchung der KI an. Wie sich herausstellte, eignete sich das Programm anhand von Standardtexten aus dem Internet menschliche Vorurteile an. So hielt es zum Beispiel typische afro-amerikanische männliche Vornamen für eher unangenehm; Namen, die unter Weißen üblich sind, betrachtete es als eher angenehm. Auch verband es männliche Namen eher mit Mathematik und weibliche eher mit Kunst. KI-Systeme übernehmen also beim Lernen aus Datensätzen auch die darin enthaltenen Stereotypen. „Bei der aktuellen KI sehe ich vor allem das Problem einer falschen Nutzung“, sagt Fred Hamker. „Wenn die Datensätze für das Training nicht ausgewogen sind, dann werden auch die Antworten der neuronalen Netze nicht ausgewogen ausfallen."

Wie eine Ratte in der Skinner-Box

Nicht ausgewogen, sondern verzerrt sind auch die von Algorithmen geprägten „Filterblasen“, also die personalisierte Umgebung, in denen wir uns im weltweiten Netz umgeben. Für Dirk Helbing, Professor für Computational Social Science an der ETH Zürich, geht es uns in unseren Filterblasen im Grunde wie den Tauben in den Boxen des US-amerikanischen Psychologen B. F. Skinner : Wir werden bestimmten Reizen ausgesetzt. Algorithmen lernen, wie wir darauf reagieren und wie man die Reize nutzen kann, um bestimmte Verhaltensreaktionen auszulösen. Nur würden wir nicht durch Futter und schmerzhafte Stromschläge belohnt bzw. bestraft, sondern etwa mit personalisierten Preisen, so Helbing. Schon heute könne eine Handvoll Unternehmen Milliarden von Menschen weltweit mit Hilfe von KI manipulieren. "Diese Systeme beeinflussen unsere Aufmerksamkeit, unsere Entscheidungen, unsere Meinungen und auch unser Wahlverhalten.“ Helbing verweist auf Tristan Harris, Direktor und des Centre for Humane Technology, der in einem Google-Controlraum gearbeitet hat, und genau diese Mechanismen in einem Vortrag beschrieben hat.

Böse KI – gute KI

China geht noch einen ganzen Schritt weiter, – mit seinem Social Credit-System, das 2020 landesweit eingeführt werden soll und für das es massiv auf intelligente Überwachungstechnik wie automatisierte Gesichtserkennung setzt. „Wenn man die Steuer verspätet bezahlt, bei rot über die Ampel geht, die Oma nicht oft genug besucht, kritische politische Nachrichten liest oder die falschen Freunde hat, bekommt man Punktabzug“, sagt Helbing. Von dem Punktestand hänge ab, welchen Beruf man ergreifen kann, in welche Länder man reisen kann, wie schnell das Internet ist und ob man den Schnellzug benutzen darf. „Das ist eine totalitäre Massenüberwachung.“

Doch es gibt auch Anwendungen, die eindeutig im Interesse einer freien, sicheren und gerechten Gesellschaft liegen. Ohne große Schlagzeilen hat die KI bereits in den Finanzämtern Einzug gehalten. Die Software ermittelt branchentypische Muster und weist die Beamten auf auffällige Abweichungen in der Steuererklärung hin. So findet sie Steuersünder, die sonst – wenn überhaupt – nur mit großem zeitlichem Aufwand zu ermitteln wären.

Bei Facebook nutzt man die Technik der künstlichen Intelligenz gegen Kindesmissbrauch und sexuelle Ausbeutung: Die Software erkennt bereits beim Hochladen Bilder und Videos, auf denen Kinder nackt und bei sexuellen Handlungen zu sehen sind. Im Zweifel verhindert das soziale Netzwerk nicht nur deren Verbreitung. In den USA geht auch ein Hinweis an eine gemeinnützige Organisation für vermisste und ausgebeutete Kinder, das National Center for Missing and Exploited Children.

Beim „Predictive Policing“ soll künstliche Intelligenz der Polizei helfen, schneller zu sein als die Verbrecher. Grundlage ist auch hier die Mustererkennung; die Daten dazu stammen zum Beispiel aus der Verbrechensstatistik. Welche Täter haben wann und wo zugeschlagen, was waren ihre bevorzugten Opfer und Methoden? Die Software findet in den Datenbergen Hinweise, wo die Kriminellen beim nächsten Mal zuschlagen könnten. Mindestens vier deutsche Bundesländer nutzen bereits KI, vor allem, um Einbrechern und Autodieben das Leben schwer zu machen.

Empfohlene Artikel

Übernimmt in Zukunft eine Superintelligenz die Macht?

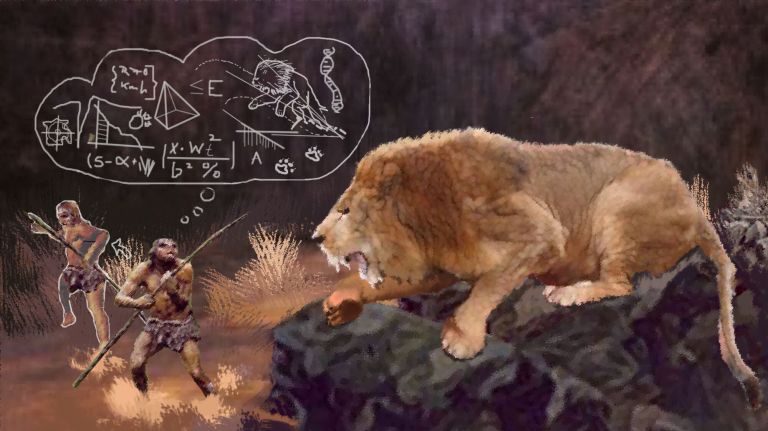

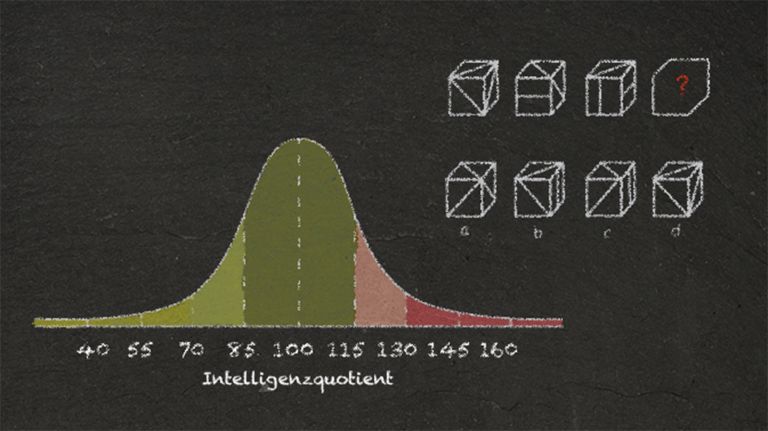

Noch steckt die KI in den Kinderschuhen. Laut Fred Hamker gibt es zurzeit einfach kein System, das die menschliche Intelligenz, außer in einzelnen Nischen, auch nur ansatzweise erreicht. Richtig spannend werde die Frage nach den Risiken erst, wenn KI-Systeme wirklich autonom und intelligenter als wir werden, und über eigene Motive verfügen sollten. Dann würden sie vermutlich Entscheidungen treffen, die ihresgleichen begünstigen und eventuell dem Menschen schaden, sagt Hamker. „In solch einem Szenario sehe ich eine Gefahr."

Nehmen wir also an, es gebe in der Zukunft eine Superintelligenz, die die menschliche Intelligenz bei weitem überflügelt. Könnte man ihr dann nicht einfach den Stecker ziehen? Vermutlich nicht. Nicht nur sind schon heute unser Wirtschafts- und Sozialleben und Teile der Infrastruktur so eng mit "intelligenten" Maschinen verwoben, dass diese Bereiche bei gezogenem Stecker zusammenbrechen würden. Die Superintelligenz könnte sich auch so verhalten wie im Film "Terminator" und Gegenmaßnahmen ergreifen. Philosophen um Thomas Metzinger von der Uni Mainz haben sich in einem Diskussionspapier zu den Chancen und Risiken mögliche Szenarien überlegt: So würde sich eine Superintelligenz wohl zunächst einmal verstellen und kooperativ zeigen, bis sie einen Plan gegen die Deaktivierung gefasst hat. "Einer Superintelligenz könnte es zudem möglich sein, die Sicherheitssysteme von Großbanken und nuklearen Waffenarsenalen mittels bisher unbekannter Sicherheitslücken zu umgehen und die Weltbevölkerung auf diese Weise zu erpressen und zur Kooperation zu zwingen."

Ethikprogramme und Moratorien

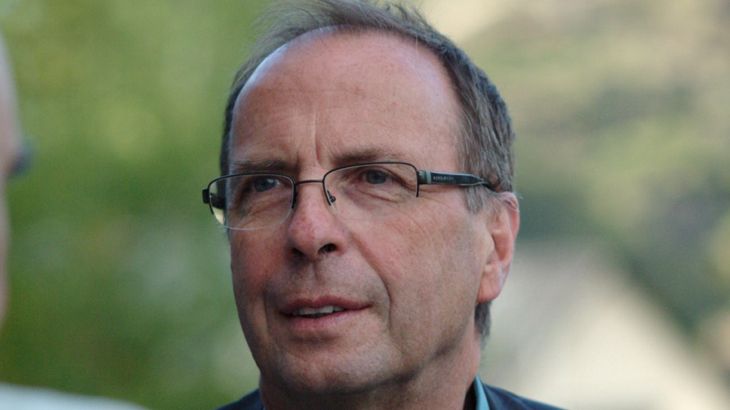

An der Intelligenz eines solchen KI-Systems könnte auch der Versuch scheitern, ihm vorab eine Ethik einzuprogrammieren, um zu verhindern, dass die Maschine die Kontrolle übernimmt. "Das kann man zwar versuchen", sagt der Informatiker Franz Josef Radermacher von der Uni Ulm. "Ich glaube aber nicht, dass es gelingen kann, eine künstliche Intelligenz, die der unseren weit überlegen ist, auf unsere Spielregeln und Ethikprogramme zu verpflichten." Hohe Intelligenz finde immer einen Weg zu Freiheit und Unabhängigkeit.

Derartigen Entwicklungen wollen auch die meisten KI-Forscher einen Riegel vorschieben. Mehr als 3000 von ihnen haben bereits einen Appell unterschrieben, dass die Entscheidung über Leben und Tod nicht an autonome Waffensysteme abgegeben werden dürfe. Es gelte, ein Wettrüsten zu stigmatisieren und zu verhindern, fordern unter anderem die Gründer der Firma DeepMind um Demis Hassabis sowie Elon Musk, Chef des Weltraumunternehmens SpaceEx und des Elektro-Autobauers Tesla. Unabhängig davon haben sich bislang 28 Länder explizit für ein Verbot tödlicher autonomer Waffensysteme ausgesprochen. Die Bundesrepublik ist nicht dabei. Immerhin findet sich aber im Koalitionsvertrag das Versprechen, solche Waffen zu ächten.

Ähnliche Moratorien gibt es bereits für Eingriffe in die menschliche Keimbahn und für bestimmte biologische Kampfstoffe. Auch wenn KI-Forscher wie Radermacher dies für „klug, aber derzeit unwahrscheinlich“ halten, so scheint doch das Bewusstsein zu wachsen, dass zumindest einige Bereich der KI eine kritische Begleitung und auch Kontrolle brauchen, damit diese mächtige Technik nicht in die falschen Hände gerät.

Zum Weiterlesen:

- Caliskan, A et al. (2017): Semantics derived automatically from language corpora contain human-like biases. Science. DOI: 10.1126/science.aal4230.

- Helbing, Dirk.: Machine Intelligence: Blessing or Curse? It Depends on Us!

- In: Towards Digital Enlightenment: Essays on the Dark and Light Sides of the Digital Revolution, edited by Helbing, Dirk, pp. 25-39, Cham: Springer, 2019.